본문

제품 정보

A Time Series is Worth 64 Words: Long-term Forecasting with Transformers

| Date | 2025.09.11 |

|---|---|

| Speaker | 김철규 |

- 이전글Do Deep Neural Network Solutions Form A Star Domain 25.09.17

- 다음글Adaptive risk minimization: learning to adapt to domain shift 25.09.01

Topic:

A Time Series is Worth 64 Words: Long-term Forecasting with Transformers

Keywords:

Time Series Forecasting

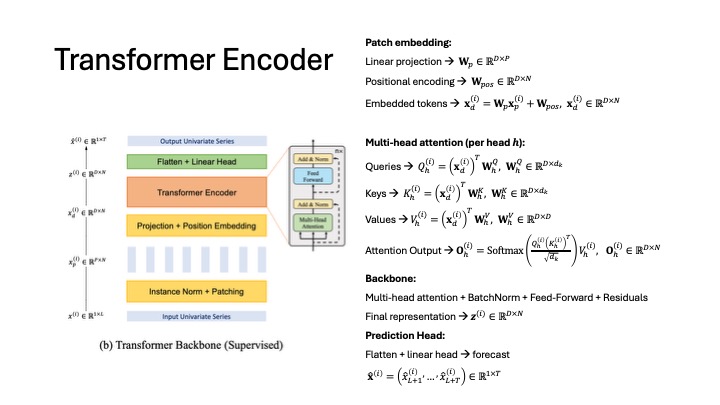

Transformer

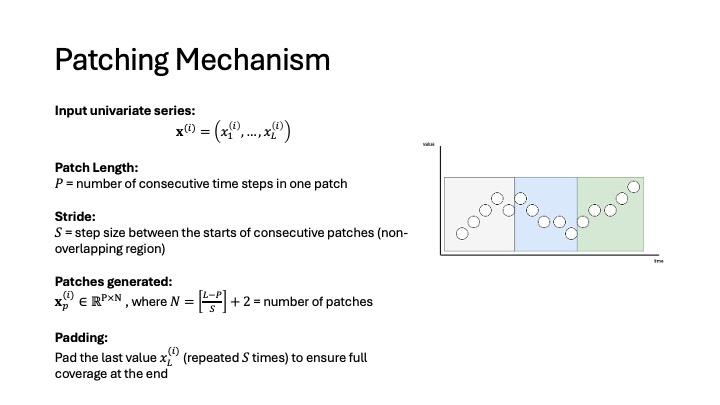

Patch Embedding

Channel-Independence

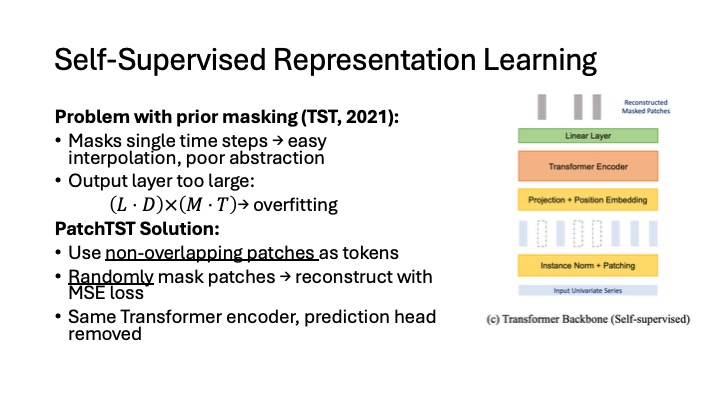

Self-Supervised Learning

Reference:

Nie, Yao, et al. "A time series is worth 64 words: Long-term forecasting with transformers." International Conference on Learning Representations (ICLR). 2023.

첨부파일

-

PatchTST.pdf (3.8M)

1회 다운로드 | DATE : 2025-09-17 09:28:35

관련링크

저작자표시-비영리-동일조건변경허락(BY-NC-SA)

저작자와 출처 등을 표시하면 저작물의 변경, 2차적 저작물의 작성을 포함한 자유이용을 허락합니다.

단 영리적 이용은 허용되지 않고 2차적 저작물에는 원저작물에 적용된 라이선스와 동일한 라이선스를 적용해야 합니다.